Nadchodzi czas fake video? Rewolucyjny algorytm naukowców z Waszyngtonu

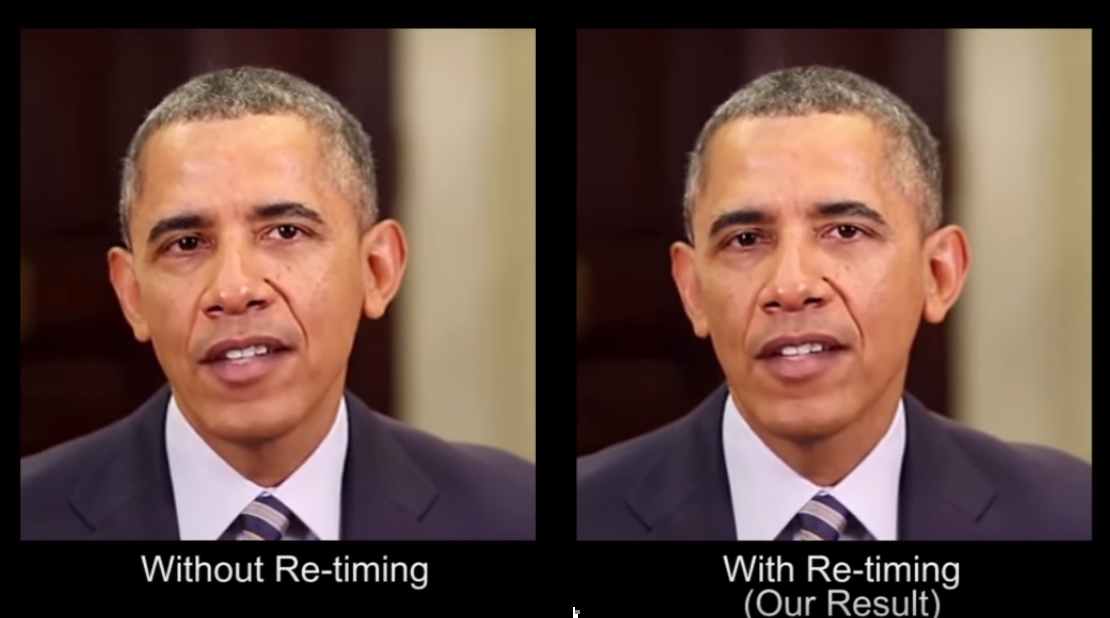

Naukowcy z Uniwersytetu w Waszyngtonie opracowali algorytm synchronizujący pliki audio oraz wideo z ruchem ust mówiącego, który może zrewolucjonizować świat wideo. Czy przy okazji pomoże on w rozwoju fake video?